"검색증강생성(RAG) 기술"의 두 판 사이의 차이

라이언의 꿀팁백과

| 11번째 줄: | 11번째 줄: | ||

생성형 AI의 환각(hallucination)을 줄이는 다른 방법으로는 학습 토큰을 늘리는 '''롱 콘텍스트(long context)''' 방법도 있다. 즉, LLM이 이해할 수 있는 문맥을 더 길게 제공해서 답변의 정확도를 높이는 기술을 말한다. | 생성형 AI의 환각(hallucination)을 줄이는 다른 방법으로는 학습 토큰을 늘리는 '''롱 콘텍스트(long context)''' 방법도 있다. 즉, LLM이 이해할 수 있는 문맥을 더 길게 제공해서 답변의 정확도를 높이는 기술을 말한다. | ||

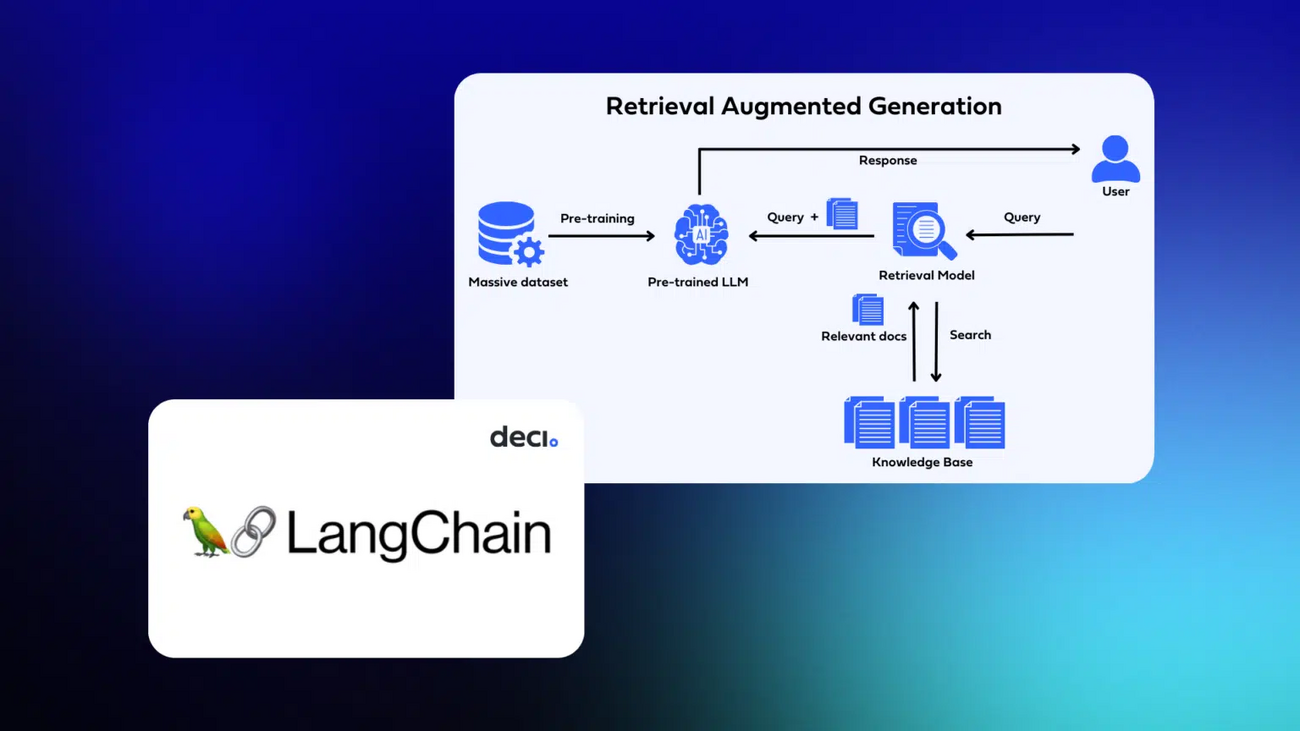

[[파일:RAG 작동방식.jpg|대체글=기사: https://byline.network/2024/02/240219_003|프레임없음|800x800픽셀]] | [[파일:RAG 작동방식.jpg|대체글=기사: https://byline.network/2024/02/240219_003|프레임없음|800x800픽셀]] | ||

2024년 2월 20일 (화) 08:46 기준 최신판

검색증강생성(Retrieval Augumented Generation, RAG) 기술은 생성형(Generative) AI 기술에서 발생하는 환각(hallucination) 현상을 해결하기 위해 제안한 방법으로 미리 학습된 LLM(대규모 언어 모델) 및 자체 데이터를 사용하여 응답을 생성하는 패턴이다. 생성 AI가 잘못 답변할 수 있는 부분에서 미리 질문과 관련된 참고 자료를 구성해 미리 학습을 시켜서 더욱 정확하고 일관성 있는 결과를 생성할 수 있다.

이에 대한 상세한 설명은 Azure Machine Learning 문서에서 LLM(대규모 언어 모델)에서 RAG 사용에 대한 기술 개요, Azure Machine Learning을 사용한 RAG(미리 보기)를 참고하면 좋다. (링크)

생성형 AI의 환각(hallucination)을 줄이는 다른 방법으로는 학습 토큰을 늘리는 롱 콘텍스트(long context) 방법도 있다. 즉, LLM이 이해할 수 있는 문맥을 더 길게 제공해서 답변의 정확도를 높이는 기술을 말한다.