VLA

라이언의 꿀팁백과

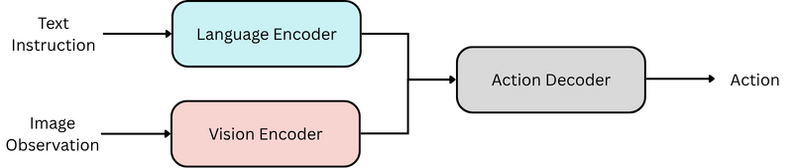

Vision Language Action Model. In robot learning, a vision-language-action model (VLA) is a class of multimodal foundation models that integrates vision, language and actions. Given an input image (or video) of the robot's surroundings and a text instruction, a VLA directly outputs low-level robot actions that can be executed to accomplish the requested task. (Source: https://en.wikipedia.org/wiki/Vision-language-action_model)

VLA 모델(Vision-Language-Action Model)은 텍스트, 비디오, 시연(Demonstration)등의 인풋을 받아 액션을 생성하는 로봇 파운데이션 모델들을 일컫는다. 즉, 인공지능 로봇에 들어가는 일종의 생성형 인공지능이다. (출처: https://namu.wiki/w/VLA)

VLA는 VLM 을 통해 통합된 정보를 기반으로 로봇이 구체적인 행동을 계획하고 실행하도록 한다. (출처: 이코노미스트)